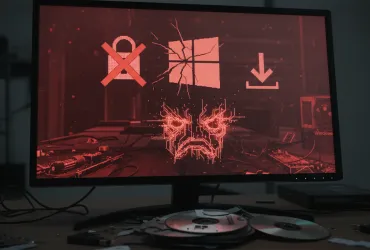

OpenAI è al lavoro per blindare il suo browser con intelligenza artificiale Atlas, ma ammette che eliminare del tutto la minaccia dei prompt injection è impossibile. I prompt injection sono attacchi in cui un agente AI esegue istruzioni nascoste, celate in aree invisibili di pagine web o email.

Come le truffe e il social engineering, anche i prompt injection sono difficili da sradicare completamente, secondo OpenAI. La stessa architettura del browser, con il suo "regime agente", amplia la superficie di attacco. Dopo il lancio di Atlas a ottobre, esperti di cybersecurity hanno subito dimostrato come manipolare il browser, ad esempio inserendo poche parole in un documento Google Docs. Anche gli sviluppatori di Brave hanno confermato che l'iniezione indiretta di prompt è un problema sistemico per i browser AI, incluso Perplexity Comet. Persino il National Cyber Security Centre britannico ha ammesso l'impossibilità di eliminare del tutto questi attacchi, suggerendo di mitigarne le conseguenze invece di tentare di "fermarli". Google e Anthropic puntano invece su una difesa a più livelli e stress test continui dei sistemi.

OpenAI ha scelto una strada diversa, creando un "attaccante automatizzato basato su un modello linguistico di grandi dimensioni". Si tratta di un bot addestrato con reinforcement learning nel ruolo di hacker, che tenta costantemente di inviare istruzioni dannose all'agente AI. Il bot testa i suoi attacchi in simulazioni, analizzando come l'AI reagisce in diverse condizioni. Impara dalle reazioni, modifica lo schema di attacco e ripete i tentativi. Questo approccio permette di scoprire vulnerabilità più rapidamente rispetto agli hacker esterni, grazie alla profonda conoscenza dei meccanismi interni dell'AI.

In una dimostrazione, il bot ha inserito un'email "avvelenata" nella casella di posta di un utente. L'AI ha scansionato la corrispondenza, aperto l'email, seguito le istruzioni nascoste e inviato una lettera di dimissioni al posto di una risposta automatica di assenza dall'ufficio. Dopo un aggiornamento di sicurezza, l'agente AI è riuscito a identificare il tentativo di prompt injection e a segnalarlo all'utente. OpenAI sottolinea che, in assenza di una protezione totale, è fondamentale affidarsi a test approfonditi e cicli di aggiornamento rapidi. L'azienda non ha fornito dati concreti sulla riduzione degli attacchi riusciti, ma ha affermato di aver iniziato a lavorare in questa direzione, anche con esperti esterni, prima del lancio di Atlas.

Gli agenti AI rappresentano una minaccia seria perché hanno un alto livello di accesso e una certa autonomia. Secondo esperti intervistati da TechCrunch, il reinforcement learning non è sufficiente: è necessario limitare le azioni che l'agente AI può compiere per conto dell'utente e richiedere conferme prima di azioni importanti. Anche OpenAI raccomanda agli utenti di Atlas di dare istruzioni specifiche all'AI, invece di concedere accesso completo alla posta e permetterle di "fare tutto il necessario". Atlas chiede conferma prima di inviare messaggi o effettuare pagamenti. OpenAI avverte che, nonostante le misure di sicurezza, un'ampia libertà di azione facilita l'azione di contenuti dannosi sull'agente. La sfida della sicurezza dei browser AI è quindi tutt'altro che risolta e richiede un impegno costante per anticipare e contrastare le nuove minacce.