Xiaomi, nota principalmente per i suoi dispositivi mobili, smart home e veicoli elettrici, ha annunciato una svolta nel campo della robotica con la presentazione di Xiaomi-Robotics-0, un modello di intelligenza artificiale open source. Questo sistema combina componenti visivi, linguistici e di azione, vantando 4,7 miliardi di parametri e aprendo nuove frontiere nell'interazione uomo-macchina.

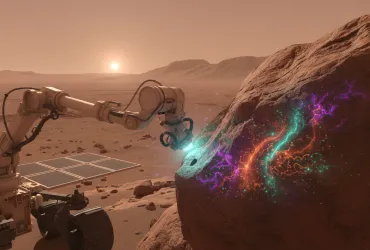

Xiaomi-Robotics-0 integra la capacità di riconoscere immagini, comprendere il linguaggio naturale e agire in tempo reale, elementi che costituiscono il nucleo dell'«intelligenza fisica». Il modello ha già stabilito nuovi standard sia in simulazioni che in test reali, dimostrando un'efficacia senza precedenti.

Tradizionalmente, i modelli di IA per robot operano in un ciclo chiuso: percepiscono l'ambiente, prendono decisioni e eseguono azioni. Xiaomi-Robotics-0 è stato progettato per bilanciare una comprensione ampia con un controllo preciso della motricità. A tal fine, utilizza un'architettura «Mixture-of-Transformers» (MoT), che distribuisce i compiti tra due componenti principali.

Il primo componente è un modello visivo-linguistico (VLM), che funge da «cervello» del sistema. Questo componente è addestrato per interpretare comandi umani, anche quelli ambigui come «piega l'asciugamano», e per comprendere le relazioni spaziali basandosi su segnali visivi ad alta risoluzione. Le funzioni principali di questa parte includono il rilevamento di oggetti, la risposta a domande in ambito visivo e il ragionamento logico.

Il secondo componente, denominato da Xiaomi «Action Expert», si basa su un'architettura Diffusion Transformer (DiT). Invece di eseguire una singola azione alla volta, questo componente genera una sequenza di azioni utilizzando metodi di соppiamneto di flussi, garantendo movimenti precisi e fluidi. Questa capacità è cruciale per compiti complessi che richiedono una coordinazione fine e una pianificazione a lungo termine.

Una sfida comune nei modelli VLM è che, durante l'addestramento per l'esecuzione di operazioni fisiche, tendono a perdere parte delle loro capacità di comprensione. Gli ingegneri di Xiaomi hanno superato questo ostacolo addestrando il modello simultaneamente su dati multimodali e dati relativi alle azioni. In teoria, ciò significa che il sistema può ragionare sugli oggetti circostanti e imparare a muoversi nell'ambiente contemporaneamente. Il processo di apprendimento è suddiviso in diverse fasi. Inizialmente, un meccanismo di «proposta di azioni» spinge il VLM a prevedere possibili distribuzioni di azioni durante l'interpretazione delle immagini. Questo aiuta ad allineare la rappresentazione interna del modello con il modo in cui vengono eseguite le operazioni. Successivamente, il componente VLM viene sospeso e il DiT viene addestrato separatamente per generare sequenze precise dal rumore basandosi su caratteristiche chiave, anziché su token linguistici discreti.

Xiaomi ha affrontato anche il problema del ritardo nell'output, ovvero la pausa tra le previsioni del modello e il movimento fisico del robot. Per risolvere questo problema, è stato implementato un output asincrono, separando i calcoli del modello dalle azioni del robot. In questo modo, i movimenti rimangono continui anche se il modello richiede più tempo per elaborare le informazioni. Per migliorare la stabilità, viene utilizzata una tecnica chiamata Clean Action Prefix, che prevede il ritorno al modello dell'azione prevista in precedenza, garantendo un movimento fluido e senza scatti. Una maschera di attenzione indirizza il modello verso la serie visiva attuale, riducendo la priorità degli stati passati, il che rende il robot reattivo ai cambiamenti improvvisi nell'ambiente.

Nelle simulazioni LIBERO, CALVIN e SimplerEnv, Xiaomi-Robotics-0 ha superato circa 30 altri modelli, secondo quanto riferito dallo sviluppatore. Nei test reali, è stato testato su un robot con due manipolatori in compiti che richiedono sequenze di azioni, come piegare asciugamani e smontare blocchi di costruzione. Il robot ha dimostrato una stabile coordinazione occhio-mano, manipolando efficacemente sia oggetti rigidi che morbidi. Il modello è riuscito a preservare forti capacità visive e linguistiche, soprattutto in compiti legati all'interazione fisica.

L'innovazione di Xiaomi apre nuove prospettive per l'automazione industriale, l'assistenza domestica e molte altre applicazioni. La capacità di comprendere comandi complessi e di adattarsi a situazioni impreviste rende Xiaomi-Robotics-0 un passo avanti significativo verso robot più intelligenti e autonomi. Resta da vedere come questa tecnologia evolverà e quali saranno i suoi impatti sul futuro della robotica e dell'intelligenza artificiale.