La crescente domanda di potenza di calcolo, alimentata dallo sviluppo esponenziale dell'Intelligenza Artificiale (IA), sta portando alla ribalta piattaforme che per anni sono rimaste nell'ombra. Un esempio lampante è rappresentato dai processori TPU (Tensor Processing Unit) sviluppati internamente da Google, che ora sono al centro di un importante accordo con Anthropic PBC per l'espansione della sua infrastruttura computazionale.

Secondo quanto riportato da Bloomberg, Anthropic PBC ha recentemente stipulato un contratto con Google per l'utilizzo di oltre 1 GW di potenza di calcolo, un affare stimato in decine di miliardi di dollari. L'accordo garantisce ad Anthropic l'accesso a 1 milione di processori TPU, progettati e gestiti nell'infrastruttura cloud del colosso di Mountain View. Fino ad ora, il principale utilizzatore di questi processori era la stessa Google, nonostante i primi modelli di questa famiglia risalgano a più di dieci anni fa. Questo non è il primo accordo tra Google e Anthropic, ma l'intensificarsi della collaborazione evidenzia il forte interesse di quest'ultima verso questi processori specializzati.

È plausibile che l'esempio di Anthropic possa spingere altre startup nel settore dell'IA a considerare l'affitto di potenza di calcolo basata su TPU da Google. Lo sviluppo di questi processori, altamente specializzati, è iniziato nel 2013, ma i primi modelli sono stati presentati solo due anni dopo. Inizialmente, i TPU erano impiegati per accelerare le prestazioni del motore di ricerca di Google. L'integrazione nell'infrastruttura cloud è avvenuta nel 2018, aprendo l'accesso a questa piattaforma anche a clienti esterni. Nel tempo, Google ha iniziato a sfruttare i TPU per alimentare i propri servizi di IA, perfezionando i processori sulla base dell'esperienza maturata nello sviluppo di tali servizi. In questo processo sono stati coinvolti anche gli esperti di DeepMind, altra società controllata da Google.

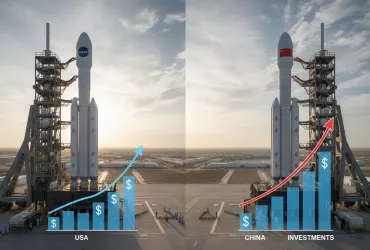

I chip di Nvidia sono ampiamente riconosciuti come più versatili e potenti in questo campo, ma presentano anche un elevato consumo energetico e costi significativi, oltre a essere soggetti a scarsa disponibilità. I TPU, nel corso della loro evoluzione, si sono adattati in modo efficace ai carichi di lavoro computazionali tipici dell'IA. Inoltre, offrono una maggiore accessibilità, consumano meno energia e richiedono sistemi di raffreddamento meno complessi. Oltre ad Anthropic, anche altre aziende come Salesforce, Midjourney e la startup SSI, fondata da Ilya Sutskever (uno dei fondatori di OpenAI), utilizzano l'infrastruttura Google basata su TPU per le proprie esigenze. È probabile che i processori TPU troveranno applicazioni anche al di fuori dell'infrastruttura cloud di Google.

Allo stesso tempo, Google continuerà a essere uno dei maggiori clienti di Nvidia, poiché i chip di quest'ultima sono più adatti a gestire le fluttuazioni nei carichi di lavoro computazionali. I processori proprietari di Google, in questo senso, si adattano meno facilmente ai cambiamenti senza modifiche hardware. L'ultima generazione di TPU, denominata Ironwood e presentata in aprile, è progettata per l'inferenza e richiede il raffreddamento a liquido. Un singolo cluster può ospitare 256 o 9216 di questi chip. Molti degli specialisti che hanno contribuito allo sviluppo dei TPU hanno trovato impiego in startup del settore IA, supportando indirettamente l'influenza di Google nel settore.

In sintesi, mentre la domanda di capacità computazionale per l'IA continua a crescere, i TPU di Google si affermano come un'alternativa valida e performante alle più blasonate GPU di Nvidia, offrendo un equilibrio tra prestazioni, efficienza energetica e costi, aprendo nuove prospettive per l'innovazione nel campo dell'intelligenza artificiale.