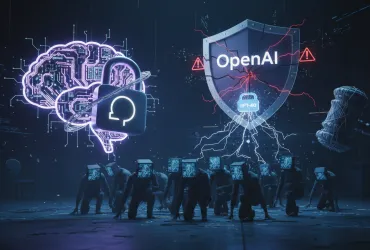

OpenAI ha presentato due nuovi modelli di intelligenza artificiale (AI) progettati per identificare diverse minacce alla sicurezza sulle piattaforme online. Questi modelli, denominati gpt-oss-safeguard-120b e gpt-oss-safeguard-20b (il numero indica il numero di parametri), sono rilasciati con licenza open con pesi aperti, offrendo agli utenti un livello di trasparenza e controllo senza precedenti. Si tratta di versioni adattate dei modelli gpt-oss annunciati in agosto.

A differenza dei modelli completamente open source, questi offrono un equilibrio tra accessibilità e controllo, consentendo alle organizzazioni di personalizzarli in base alle proprie politiche specifiche. Una caratteristica distintiva è la capacità di questi modelli di fornire 'catene di ragionamento', offrendo agli sviluppatori una comprensione chiara del processo decisionale dell'AI. Questo aspetto è cruciale per la trasparenza e la responsabilità, consentendo di capire come il modello giunge a una particolare conclusione.

Le applicazioni pratiche di questi modelli sono ampie e variegate. Ad esempio, su un sito di recensioni, la serie gpt-oss-safeguard può essere utilizzata per filtrare recensioni ritenute false, contribuendo a mantenere l'integrità delle informazioni online. In un forum di videogiochi, può rimuovere automaticamente i messaggi relativi a schemi di cheating, contribuendo a creare un ambiente di gioco più equo e sicuro. Questi sono solo due esempi di come l'AI può essere impiegata per proteggere le comunità online da comportamenti dannosi.

OpenAI ha sviluppato questi modelli in collaborazione con diverse organizzazioni, tra cui Discord, SafetyKit e ROOST, quest'ultima specializzata nell'infrastruttura di sicurezza per i sistemi di IA. La collaborazione con Discord sottolinea l'importanza della sicurezza nelle piattaforme di comunicazione online, mentre il coinvolgimento di SafetyKit e ROOST evidenzia l'attenzione di OpenAI verso la creazione di sistemi di IA sicuri e affidabili.

Attualmente, i modelli sono disponibili in versione preliminare per i ricercatori, con l'obiettivo di raccogliere feedback e perfezionare ulteriormente le loro capacità. Questo approccio iterativo, che coinvolge esperti del settore, è fondamentale per garantire che i modelli siano efficaci e sicuri nel mondo reale. L'iniziativa di OpenAI rappresenta un passo significativo verso la democratizzazione dell'accesso alla tecnologia di sicurezza AI, consentendo a un'ampia gamma di organizzazioni di beneficiare delle sue capacità. La disponibilità di modelli con pesi aperti promuove l'innovazione e la collaborazione nella comunità della sicurezza AI, aprendo la strada a nuove applicazioni e miglioramenti futuri. L'impegno di OpenAI nel fornire strumenti trasparenti e personalizzabili per la sicurezza online è un segnale positivo per il futuro di Internet, dove la protezione degli utenti e l'integrità delle informazioni sono di primaria importanza.

In un panorama digitale in continua evoluzione, dove le minacce alla sicurezza diventano sempre più sofisticate, l'adozione di soluzioni di IA come gpt-oss-safeguard è fondamentale per proteggere le piattaforme online e garantire un'esperienza utente sicura e affidabile. L'iniziativa di OpenAI dimostra il potenziale dell'IA nel contrastare le attività dannose e promuovere un ambiente online più sicuro per tutti.